Dans deux billets récents, je parlais de critiques de la méga-analyse Visible Learning (analyse de 800 méta-analyses regroupant 50 000 études individuelles sur plus de 200 millions de sujets). Le premier billet parlait notamment de limites inhérentes aux méta-analyses. Le deuxième, de positions théoriques ou idéologiques sous-tendant une interprétation répandue (et plutôt stricte) du courant de pratiques éducatives fondées sur des données probantes. Ici, je parlerai de critiques des statistiques utilisées par John Hattie dans Visible Learning.

Deux statistiques principales

Mais avant de critiquer, voyons ce qui est décrit comme la grande force des statistiques compilées dans Visible Learning. Citons Normand Baillargeon (2014) qui parle d’une des deux statistiques compilées, soit la taille d’effet (effect size) :

Il se trouve cependant qu’en éducation, du seul fait de proposer un enseignement et du seul fait de la maturité des sujets, tout ce qu’on fait, ou presque, a un effet positif. […] on veut savoir ce qui marche plus et mieux, et pas seulement ce qui marche de toute façon, du seul fait que c’est pratiqué sur des sujets qui maturent.

Ce qui marche de la sorte, ce qui marche de toute façon, a une ampleur d’effet que la méga-analyse permet de situer à 0.4, sur une échelle qui va de -0.2 à 1.2. La zone recherchée de nos interventions en éducation sera donc au-delà de ce 0.4, autrement dit devra avoir un effet d’une ampleur supérieure à ce que n’importe quelle méthode, ou presque, produit. [Notre emphase]

Une taille d’effet de 0.4 signifie que les apprenants qui ont reçu la condition expérimentale ont des résultats en moyenne 0.4 écarts-types plus élevés que ceux ayant reçu la condition contrôle (Clark, Nguyen et Sweller, 2006, p. 339).

Dans Visible Learning, Hattie rapporte deux statistiques pour chaque pratique pédagogique qu’il a analysé :

- comme déjà mentionné, la taille d’effet, une mesure qui a gagné en popularité dans les dernières années pour les raisons expliquées par Baillargeon dans la citation précédente;

- la Common Language Effect Size (abrégée CLE), qui est un calcul de probabilité que Hattie juge essentiel pour interpréter correctement la taille d’effet. Une explication :

[…] the CLE is, as I understand it, an effect measure intended to be more intuitively understandable for the average non-expert-statistician reader. In short, the CLE size is the probability that one randomly selected sample from one distribution (e.g. of scores on a test) will be greater or smaller than one randomly selected sample from another distribution. […]Consider a difference in male (5’10”/177,5 cm) and female (5’4”/162,5 cm) average height. The effect size […] is 2.0, considered very large, and the calculated CLE will be 92 per cent. The CLE percentage then says that, if you pick a random man and a random woman from the two respective populations, there is a 92 per cent chance that the man would be taller than the woman. Thus, in 92 out of 100 couples selected for blind dates, the man would be taller than the woman. (The “effect” in this case would be something like the effect of gender on average height.) Note that it does not say anything about how much taller – only the probability of a difference in heights in favor of one of the populations compared with the other […].

(If men and women had the exact same average size, in a random selection from each group there would be a 50 per cent chance for the man to be the tallest – and a 50 per cent chance for the woman to be tallest […] (Solfjell, 2012a) [Nos emphases]

Des erreurs systématiques pour une des statistiques principales

Et c’est avec la CLE que le bât blesse. Une probabilité est toujours exprimée de façon positive en 0 et 1 (ou entre 0 et 100%). « Thus, any CLE size has to be a percentage between 0 and 100. A positive effect would give a percentage between 51 and 100; a negative would give a percentage between 0 and 49 per cent; and no effect, i.e. no difference between populations, would give a CLE of 50 per cent. » (Solfjell, 2012a).

Hors, Hattie rapporte des CLE allant de -49% jusqu’à 219%!

Non seulement Hattie donne-t-il des statistiques hors de la plage de 0 à 100%, en plus il démontre une incompréhension fondamentale du concept de CLE dans Visible Learning : «The CLE is 21 per cent so that in 21 times out of 100, introducing homework into schools will make a positive difference, or 21 per cent of students will gain in achievement compared to those not having homework. » (Hattie, 2009, cité dans Solfjell, 2012a). Solfjell cite 3 problèmes importants avec cette façon d’interpréter la mesure de CLE (voir l’article original pour les détails).

C’est le professeur de statistiques Arne Kåre Topphol de la University College of Volda en Norvège qui a souligné ces problèmes majeurs dans un article publié dans un journal norvégien de pédagogie en 2011 (* voir note de bas de page). Il a ensuite eu un échange public avec Hattie à ce sujet.

En gros, Hattie a fini par admettre son erreur, mais en en minimisant l’importance.

Pas si vite disent les critiques. Si la taille d’effet, du propre aveu de Hattie, ne peut s’interpréter correctement qu’avec la CLE, elle perd son sens ou du moins elle brosse un tableau trompeur si la CLE est incorrecte, disent-ils.

Dans un 2e billet de son blogue, Solfjell (2012b) a donné l’occasion à Hattie de répondre à son premier billet. Il a aussi permis à Topphol de répondre à son tour. Les deux chercheurs ont acquiescé. Malheureusement, les deux textes ne sont plus accessibles (liens brisés).

Un autre blogueur qui se décrit comme un bachelier en mathématiques avec majeure en statistiques et maintenant enseignant en mathématiques (identifié seulement par son compte d’utilisateur WordPress ollieorange2) est encore plus dur dans ses critiques. Il donne une explication claire de l’erreur de calcul de Hattie. Cependant, il dépasse largement la critique de Visible learning, remettant en question la pertinence même des mesures de taille d’effet et de CLE, parce que, selon lui, les mathématiciens ne les utilisent pas, et qu’elles seraient des mesures inventées par des personnes en sciences sociales qui n’ont pas le bagage mathématique nécessaire pour de telles entreprises. Il y a certainement matière à débat à ce sujet…

À la défense de Hattie

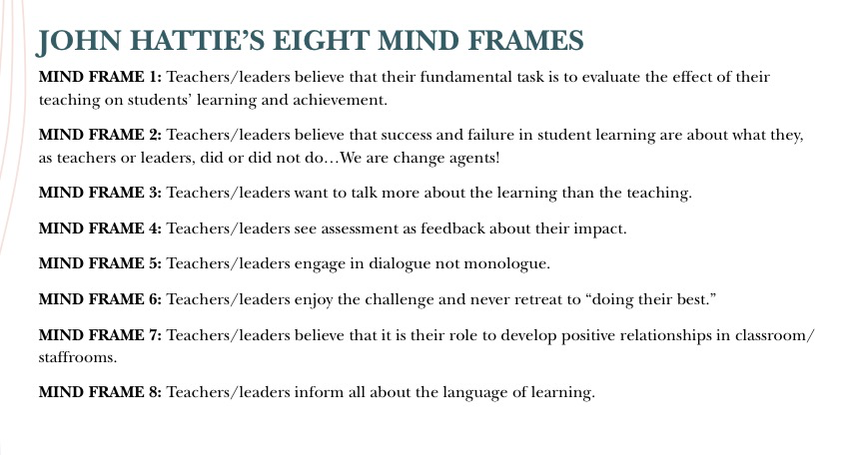

Lord (2015) cherche à ré-équilibrer le débat. Selon lui, on a trop accordé d’importance à ce débat statistique alors que ce que Hattie propose va bien au-delà de recommander des pratiques validées par sa méga-analyse. Lord nous pointe vers la suite de Visible Learning, intitulée Visible Learning for Teachers (2012), où Hattie propose 8 attitudes ou façon de penser (mindframes) à adopter qui transcendent les listes de pratiques validées statistiquement. Extrait du billet de Lord :

Lord croit que de trop s’arrêter aux statistiques fait perdre de vue le portrait global, qui n’en est pas un de listes de tailles d’effets (bien que ces listes soient très souvent mises en évidence), mais plutôt une incitation à adopter une posture réflexive informée par la recherche enseignement, tout en étant toujours bien ancrée dans le contexte spécifique de l’enseignant.

I think that many would be surprised to learn that it is these mind frames that constitute the core of Visible Learning for Teachers (2012). Although derived from some of the most academic of research (meta-analyses of meta-analyses), these mindframes suggest an approach to teaching that is very context driven and flexible, driven by adopting a more conscious approach to our work as teachers and a more deliberate, and diligent, effort to gather information about the impact we have on learning. It is perhaps for this reason that I find the controversy of Hattie’s work so vexing.

A teacher’s scarcest resource is time. It can be difficult, given the constraints, for teachers to engage deeply with research. Subtleties or nuances of arguments laid out across hundreds of pages are often reduced to sound bites and infographics. My concern is that, in imputing motives and narrowing the focus to a single artifact, we risk missing out on the value that may otherwise be gleaned and, instead, end up wasting more of our precious time. (Lord, 2015) [Nos emphases]

Conclusion

Alors, doit-on faire confiance aux statistiques de Visible Learning? Si la réponse est non, l’ensemble de la méga-analyse repose sur des bases extrêmement fragiles.

Soyons honnêtes : peu de praticiens en éducation ont les connaissances requises pour analyser et critiquer de telles analyses statistiques. Les praticiens se fient aux chercheurs pour avoir bien fait leurs devoirs et ensuite appliquer leurs découvertes dans les pratiques éducatives. Et pas seulement aux chercheurs qui font les découvertes, mais aussi à leurs pairs les qui évaluent. Il semble ici que les deux aient manqué à leurs devoirs.

S’il est inquiétant que ces erreurs n’aient pas été détectées et corrigées avant la publication, il est aussi inquiétant que la découverte de ces erreurs n’ait pas été faite plus tôt une fois le livre publié et qu’elle n’ait pas eu plus de résonance dans la communauté. D’autant plus en considérant le nombre de personnes et d’organisations ont engagé des changements importants dans leurs pratiques suite à la publication de Visible Learning.

Mais si Lord nous dit de prendre un pas de recul et de ne pas voir que les statistiques de Visible Learning, qu’en est-il de tous ceux qui ont pris des décisions de pratiques éducatives en se basant sur cet ouvrage et sur ses suites? L’ont-ils fait essentiellement à partir de listes de statistiques qui cachent des réalités bien plus complexes? Ou l’ont-ils plutôt fait dans une perspective réflexive et nuancée comme celle que Lord défend?

C’est peut-être la chose qui aura, en définitive, le plus d’impact.

Sources

Auteur inconnu surnommé ollieorange2 (2014) :

- John Hattie admits that half of the Statistics in Visible Learning are wrong

- John Hattie admits that half of the Statistics in Visible Learning are wrong (Part 2)

- The ‘Effect Size’ is not a recognised mathematical technique

Baillargeon, Normand (2014) Visible Learning. Voir.

Clark, Ruth, Nguyen, Frank. & Sweller, John (2006). Efficiency in learning : evidence-based guidelines to manage cognitive load.Pfeiffer. 389 pages.

Lilley, George (2016) An investigation of the evidence John Hattie presents in Visible Learning.

Lilley, George (sans date) CLE & Other Errors.

Lord, Stuart (2015) Effective debate: in defence of John Hattie.

Solfjell, Eivind (2012a) Did Hattie get his statistics wrong?

Solfjell, Eivind (2012b) Did Hattie get his statistics wrong II: Comments from John Hattie and Arne Kåre Topphol.

* Référence originale : “Can we trust the use of statistics in educational research” (“Kan vi stole på statistikkbruken i utdanningsforskinga”) (Topphol, 2011), publié dans le Norwegian Journal of Pedagogy (Norsk pedagogisk tidsskrift)

Pour ce faire, Hattie a repris la méthode des méta-analyses, bien connue en médecine, qui consiste à synthétiser plusieurs recherches empiriques, d’un même standard de qualité et portant sur les mêmes objets. L’idée est simple : si la plupart des études indique un effet positif ou négatif du processus étudié, on peut en tirer une conclusion scientifique probante. Sinon, l’effet est jugé non-significatif. Hattie a perfectionne le dispositif, en proposant de rassembler un grand nombre de méta-analyses dans une sorte de méga-analyse en éducation.